▶ 국내 최초 클라우드 기반 NPU 인프라, 리벨리온의 고성능 NPU ‘아톰’ 탑재

▶ 클릭 몇 번으로 NPU 사용 편의성↑, AI 분야 기간·비용 혁신

▶ 국산 AI 반도체 유일 부동 소수점 연산 지원 ‘아톰’, 외산 GPU 대비 고성능 입증

▶“AI 인프라 혁신과 AI 반도체 고도화로 대한민국 초거대 AI 활성화에 앞장설 것”

초거대 AI 연구∙개발을 위한 NPU(AI반도체) 인프라를 온라인 전용 포털에서 클릭 몇 번만으로 쉽게 이용할 수 있게 됐다.

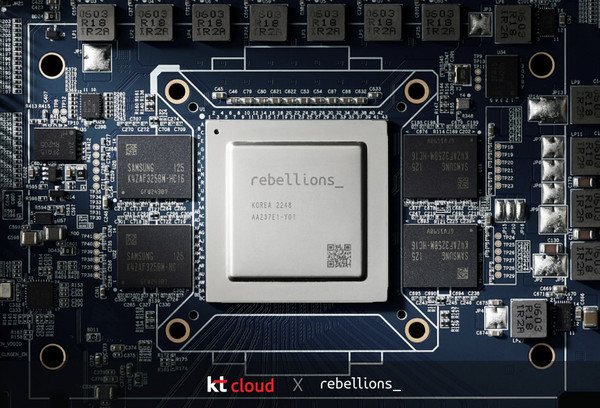

kt cloud(대표 윤동식, www.ktcloud.com)는 토종 팹리스*(반도체 설계 전문기업) 리벨리온의 '아톰'을 적용한 클라우드 기반 NPU(신경망처리장치)* 인프라 서비스를 국내 최초로 상용화하고 지난 5월 30일부터 서비스를 개시했다고 27일 밝혔다.

NPU는 AI 분야에 최적화된 설계로 AI 반도체로 불리며, 동급의 GPU *대비 연산 속도가 빠르고 전력 소모는 낮아 AI 연구∙개발 기간과 비용의 혁신을 가져온다. 이같은 장점으로 초거대 AI 산업을 위해 국내 다양한 팹리스와 클라우드 사업자(CSP)가 협력하고 있으며, NPU 개발 및 서비스화에 대한 관심이 뜨겁다.

* 1) 팹리스(Fabless): 반도체 설계 전문 회사로, 제조 설비(fabrication)와 리스(less)의 합성어

* 2) NPU(Neural Processing Unit, 신경망처리장치)

* 3) GPU(Graphic Processing Unit, 그래픽처리장치)

▶ 국내 첫 클라우드 기반 NPU 인프라, 리벨리온 고성능 NPU ‘아톰’ 탑재

이 가운데 kt cloud가 리벨리온과 협력하여 글로벌 시장에서도 고성능을 인정받은 NPU ‘아톰’을 탑재한 클라우드 기반 NPU 인프라를 최초로 상용화했다. 정부가 추진하는 ‘K-클라우드 프로젝트’ 중 국산 AI 반도체 개발, 이를 데이터센터에 적용해 국내 클라우드 경쟁력을 강화한다는 정책 등에 가장 발 빠르게 대응하고 있는 것이다.

kt cloud는 NPU를 클라우드 기반으로 이용할 수 있도록 플랫폼에 적용하고, NPU 자원 공유 풀 구성/관리 및 오토 프로비저닝 구현 등을 통해 서비스화 했다. 기업들은 전용 포털을 통해 쉽고 간편하게 NPU 기반의 AI 추론을 진행할 수 있다.

▶ 클릭 몇 번으로 NPU 사용 편의성↑, AI 분야 기간·비용 혁신

클라우드 기반 NPU 인프라는 클릭 몇 번으로 고객이 직접 자원을 생성하고, 연산 세션을 활용하고, 관리/모니터링 등을 할 수 있어 구축형 인프라 대비 사용 편의성이 높다. 더불어 고성능·저전력의 NPU 특성이 필요할 때, 필요한 만큼 이용할 수 있는 환경을 제공함으로써 AI 분야 기업들의 연구 기간·비용 혁신을 한번 더 가져온다.

이 서비스는 언어 및 비전 모델 지원이 필요한 관제, 의료 등 이미지 처리 기반 산업 분야와 고객 서비스, 교육 등 자연어 처리 기반 산업 분야의 다양한 기업들에게 제공된다.

kt cloud는 NPU 인프라를 AI반도체 초기 시장 수요 창출 지원, 중소·벤처기업 대상 국산 AI반도체 기반 컴퓨팅 자원 지원을 목적으로 하는 ‘K-클라우드 프로젝트’ 지원사업 중 ‘AI바우처 지원사업’과 ‘고성능컴퓨팅 지원사업’ 대상 기업에게 먼저 제공하고, 올해 하반기 중 기업 고객 대상으로 서비스를 확대할 계획이다.

▶ 국산 AI 반도체 유일 부동 소수점 연산 지원 ‘아톰’, 외산 GPU 대비 고성능 입증

이번 서비스에 탑재된 리벨리온의 ‘아톰’은 금융 거래에 특화된 AI 반도체 '아이온'에 이어 리벨리온이 두번째로 선보이는 AI 반도체로, 국내 타 팹리스가 개발중인 2세대 NPU 수준의 성능을 이미 갖춘 상태다.

아톰은 트랜스포머 언어 모델 * 과 부동 소수점 연산 * 을 지원하는 유일한 국산 NPU다. 세계에서 가장 공신력 있는 것으로 알려진 AI 반도체 기술력 검증 대회인 ‘엠엘퍼프(MLPerf)’ 결과에 따르면, 아톰은 엔비디아의 A2와 T4, 퀄컴의 클라우드 AI 100 대비, 영상처리(ResNet)의 경우 1.4배~3.4배, 언어 모델(BERT-Large)은 1.4배~2배 빠른 것으로 확인됐다.

게다가 최대 60 와트(Watt) 저전력 설계와 삼성 5나노 EUV(극자외선) 공정 제조로 업계에 주로 사용 중인 GPU와 비교하면 비전모델은 약 6배, 언어모델은 약 2배 전력 효율이 높아 전력 소모량을 획기적으로 줄였다.

리벨리온은 아톰의 성능을 보다 업그레이드한 버전도 준비 중이며, 이에 맞춰 kt cloud의 NPU 인프라를 고도화하고, '24년 이후에는 차기 NPU모델인 ‘리벨(Rebel)’을 선보일 계획이다.

* 4) 트랜스포머 언어 모델 : 자연어를 다른 국어로 번역해주는 기계 번역 모델

* 5) 부동 소수점 연산(floating-point operation) : 컴퓨터 실수 인식법. 연산 속도를 나타내는 단위 플롭스(FLOPS)는 초당 연산 횟수를 의미하며, 높을수록 고성능 연산이 가능함.

▶ “AI 인프라 혁신과 AI 반도체 고도화로 대한민국 초거대 AI 활성화에 앞장설 것”

리벨리온 박성현 대표는 이번 NPU 인프라 서비스에 대해 “최근 엠엘퍼프에서 비전과 언어 모델 모두에서 글로벌 탑티어 수준의 역량을 입증한 아톰이 kt cloud의 클라우드 서비스를 통해 데이터센터에 상용된 데 큰 자부심이 있다. 리벨리온의 기술력을 토대로 대한민국 AI산업 활성화에 기여하고, 앞으로도 AI반도체 시장을 리딩해 갈 것"이라고 밝혔다.

kt cloud는 향후 NPU 팜(Farm)과 클라우드 플랫폼을 설계∙구축하고, 다양한 AI 응용서비스 실증을 통해 AI 반도체 레퍼런스를 확보할 계획이다. 또, 다양한 기술 협력으로 저비용·고성능·고효율의 AI 인프라 혁신을 선도하고, 국산 AI반도체, S/W스택, 클라우드 플랫폼, AI 응용서비스까지 아우르는 AI 풀스택(Full-Stack)을 완성함으로써 2025년까지 글로벌 시장에 진출한다는 목표다.

kt cloud 윤동식 대표는 “kt cloud는 초거대 AI를 위한 종량제 AI 인프라 서비스인 하이퍼스케일 AI 컴퓨팅(HAC)을 출시해 AI 산업의 문턱을 낮춘데 이어, 국내 최초 클라우드 기반 NPU 인프라 상용화로 AI 분야 혁신을 이끌고 있다. 앞으로도 AI 인프라 혁신과 AI 반도체 고도화로 대한민국 초거대 AI 산업 활성화에 앞장 설 것”이라고 밝혔다.

'News > Press Release' 카테고리의 다른 글

| kt cloud - 이노그리드, 클라우드 시장 확대를 위한 업무협약 체결 (0) | 2023.10.17 |

|---|---|

| kt cloud-한전KDN, 에너지 공공분야 클라우드 사업 협력 (0) | 2023.06.30 |

| kt cloud, 6,000억 투자유치 성공∙∙∙대한민국 DX 산업 리딩 ‘청신호’ (0) | 2023.05.15 |

| kt cloud, 중소 핀테크 기업에 맞춤형 금융 클라우드 지원한다 (1) | 2023.05.10 |

| kt cloud, 컨테이너 인프라 서비스 'K2P Standard'···'공공 클라우드'에 출시 (0) | 2023.05.02 |